机构名称:

¥ 1.0

可解释人工智能 (XAI) 在实现人类对深度学习系统的理解和信任方面发挥着至关重要的作用。随着模型变得越来越大、越来越普遍、越来越深入日常生活的各个方面,可解释性对于最大限度地减少模型错误造成的不利影响是必不可少的。不幸的是,以人为本的 XAI 中的当前方法(例如医疗保健、教育或个性化广告中的预测任务)倾向于依赖于单一的事后解释器,而最近的研究发现,当应用于底层黑盒模型的相同实例时,事后解释器之间存在系统性分歧。因此,在本文中,我们呼吁采取行动来解决当前最先进解释器的局限性。我们建议从事后可解释性转向设计可解释的神经网络架构。我们确定了以人为本的 XAI 的五个需求(实时、准确、可操作、人性化解释和一致性),并提出了两种可解释设计神经网络工作流程方案(使用 InterpretCC 进行自适应路由和使用 I2MD 进行时间诊断)。我们假设以人为本的 XAI 的未来既不在于解释黑匣子,也不在于恢复传统的可解释模型,而在于本质上可解释的神经网络。

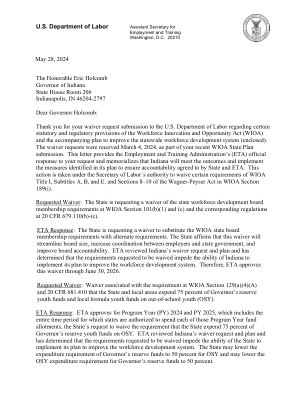

arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日

主要关键词

![arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日PDF文件第1页](/bimg/4/401f7ddeaf0795767e47aab5ee1f8f3692a30972.webp)

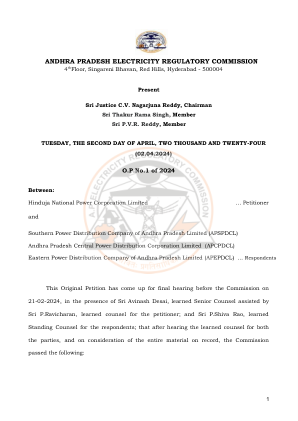

![arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日PDF文件第2页](/bimg/d/dd3f3cefcf124b1ef443b5c41d3def9d85ce5b1e.webp)

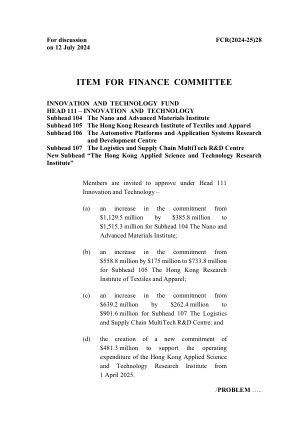

![arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日PDF文件第3页](/bimg/3/304b28656dbf2358f9fb68ca5cd83944f1c2f9e8.webp)

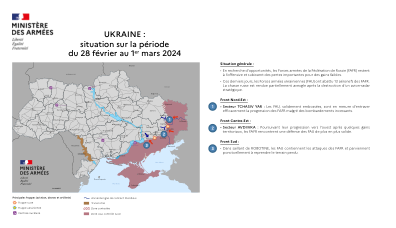

![arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日PDF文件第4页](/bimg/2/2526a4e0cf6fd3e91a4ea460b7ee0bf298582def.webp)

![arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日PDF文件第5页](/bimg/2/2bfb9bfbc67c26cb89e547bd4b11e8bab1adac9b.webp)

![arXiv:2307.00364v2 [cs.LG] 2024 年 5 月 28 日](/simg/a/a6e1b4d82219ab22304fde72b617fd5fbb6bdfe6.png)

![arXiv:2312.10370v2 [cs.AI] 2024 年 3 月 28 日](/simg/9/91f7af3b87a107a56902207b93b27804eae3aa2b.png)

![arXiv:2311.03764v4 [cs.LG] 2024 年 3 月 2 日](/simg/6/65d1deaefd3b0ae77e262828e98179c63a5a5134.png)

![arXiv:2403.00669v1 [cs.LG] 2024 年 3 月 1 日](/simg/6/6d2cba03da31fad9740548417433eee9d023508e.png)

![arXiv:2401.02344v1 [cs.LG] 2024 年 1 月 4 日](/simg/3/33969f2d6df82554df6878e78b2420d22a4c30e8.png)

![arXiv:2403.18486v1 [cs.LG] 2024 年 3 月 27 日](/simg/b/b8126dc36ca7c3b3066b8cdc012c95e254ab1d22.png)

![arXiv:2406.10729v1 [cs.LG] 2024 年 6 月 15 日](/simg/1/1d883a67dcaed3567e697f15cdb19f604e910a1e.png)

![arXiv:2401.06899v1 [cs.LG] 2024 年 1 月 12 日](/simg/4/4c9775c122729d279ec2c6eb58cdf72cd726385d.png)

![arXiv:2402.05138v1 [cs.AI] 2024 年 2 月 6 日](/simg/a/a88ffeefc81f01e0c2bd0166d654268028a7ad0c.png)

![arXiv:2101.11844v1 [cs.AI] 2021 年 1 月 28 日](/simg/0/0d5ef59b56f0580056ece4d763c75afa4d2bd407.png)

![arXiv:2110.11385v3 [cs.AI] 2024 年 2 月 29 日](/simg/0/0dd4026aa24ddd39f4a46f7995d9b38f822905d2.png)

![arXiv:2212.11338v4 [quant-ph] 2024 年 3 月 4 日](/simg/e/efd02522df234e012654bd966ec8f49dd66e15d5.png)

![arXiv:2310.12419v2 [cs.CR] 2024 年 6 月 6 日](/simg/f/f0c960cb0da1202222e3b6f934d6ea05a542d293.png)

![arXiv:2303.07032v2 [quant-ph] 2024 年 3 月 8 日](/simg/1/1283ae2309f857fb79f8cccaf49afe4bb71331cf.png)

![arXiv:2403.04126v1 [quant-ph] 2024 年 3 月 7 日](/simg/d/d55344bb07be919afc9681f99d6383148c6b3024.png)

![arXiv:2410.01044v1 [cs.AI] 2024 年 10 月 1 日](/simg/d/d341e50772fb4978a760f816a937ef4cd89c186a.png)